在使用Hadoop MapReduce框架进行数据处理时,initTableMapperJob是一个常用的方法,用于配置和启动基于HBase表的MapReduce作业,在实际应用中,开发者可能会遇到各种问题导致作业报错,本文将详细分析initTableMapperJob报错的原因,并提供解决方案。

initTableMapperJob报错原因及解决方法

1. 驱动包缺失

原因:当运行MapReduce程序时,如果找不到MySQL驱动包,会抛出java.io.IOException: com.mysql.jdbc.Driver错误。

解决方法:

确保每个节点下的${HADOOP_HOME}/lib目录下添加了MySQL驱动包。

在提交MapReduce作业前,通过以下代码将驱动包添加到Classpath中:

- DistributedCache.addFileToClassPath(new Path("/hdfsPath/mysqlconnectorjava5.1.0bin.jar"), conf);

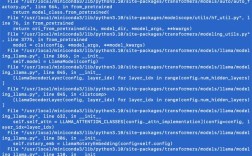

2. HBase配置问题

原因:在Windows环境下测试时,使用TableMapReduceUtil.initTableMapperJob()方法可能会导致配置问题。

解决方法:

尽量避免在Windows环境下直接使用该方法。

根据TableMapReduceUtil.initTableMapperJob()的源码进行手动配置,确保所有必要的HBase配置参数都已加载。

3. 输入格式设置错误

原因:initTableMapperJob方法需要指定输入格式类,默认为TableInputFormat。

解决方法:

确保在调用initTableMapperJob方法时,正确设置了输入格式类:

- job.setInputFormatClass(TableInputFormat.class);

4. 依赖Jar包未上传

原因:如果未设置addDependencyJars参数为true,可能导致HBase相关的Jar包未被上传,从而引发错误。

解决方法:

在调用initTableMapperJob方法时,将addDependencyJars参数设置为true:

- TableMapReduceUtil.initTableMapperJob("student", new Scan(), ScanHbaseMapper.class, Text.class, CacheData.class, job, true);

5. Mapper和Reducer类配置错误

原因:自定义Mapper和Reducer类时,需要指定正确的泛型类型。

解决方法:

确保Mapper类正确继承自TableMapper,并指定输出Key和Value的类型:

- public class MyMapper extends TableMapper<Text, CacheData> {

- // 实现map方法

- }

确保Reducer类正确继承自TableReducer,并指定输入Key、Value以及输出Key的类型:

- public class MyReducer extends TableReducer<Text, CacheData, Text, Mutation> {

- // 实现reduce方法

- }

示例代码

以下是一个完整的示例代码,展示了如何使用initTableMapperJob方法配置和运行一个HBase到MySQL的数据迁移作业:

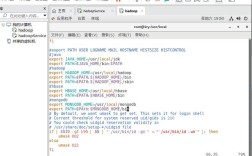

- import org.apache.hadoop.conf.Configuration;

- import org.apache.hadoop.hbase.client.Scan;

- import org.apache.hadoop.hbase.mapreduce.TableMapReduceUtil;

- import org.apache.hadoop.mapreduce.Job;

- import org.apache.hadoop.mapreduce.Mapper;

- import org.apache.hadoop.mapreduce.Reducer;

- import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

- import org.apache.hadoop.io.Text;

- import java.io.IOException;

- public class HBase2MysqlTool {

- public static void main(String[] args) throws Exception {

- Configuration conf = HBaseConfiguration.create();

- Job job = Job.getInstance(conf, "HBase to MySQL");

- job.setJarByClass(HBase2MysqlTool.class);

- // 初始化Mapper作业

- TableMapReduceUtil.initTableMapperJob(

- "student", // 表名

- new Scan(), // 扫描器

- ScanHbaseMapper.class, // Mapper类

- Text.class, // 输出Key类型

- CacheData.class, // 输出Value类型

- job, // Job对象

- true, // 添加依赖Jar包

- TableInputFormat.class // 输入格式类

- );

- // 设置Reducer类

- job.setReducerClass(Hbase2MysqlReducer.class);

- job.setOutputKeyClass(Text.class);

- job.setMapOutputValueClass(CacheData.class);

- job.setOutputFormatClass(MysqlOutputFormat.class);

- // 等待作业完成

- int status = job.waitForCompletion(true) ? JobStatus.State.SUCCEEDED.getValue() : JobStatus.State.FAILED.getValue();

- System.out.println("Job completed with status: " + status);

- }

- }

initTableMapperJob是Hadoop MapReduce框架中用于处理HBase表数据的重要方法,在实际使用中,可能会遇到驱动包缺失、配置问题、依赖Jar包未上传等多种问题,通过本文提供的详细分析和解决方法,开发者可以更好地理解和解决这些问题,确保MapReduce作业顺利运行。

相关问答FAQs

Q1: 如何在Windows环境下避免使用TableMapReduceUtil.initTableMapperJob()方法导致的配置问题?

A1: 在Windows环境下,建议根据TableMapReduceUtil.initTableMapperJob()的源码进行手动配置,确保所有必要的HBase配置参数都已加载,具体步骤包括设置输入格式、添加依赖Jar包等。

Q2: 如果initTableMapperJob方法抛出IOException,可能是什么原因?

A2:initTableMapperJob方法抛出IOException的常见原因包括驱动包缺失、HBase配置问题、输入格式设置错误等,解决方法包括确保驱动包存在、正确设置输入格式、检查HBase配置等。