在处理数据科学项目时,创建数据集是至关重要的一步,在这个过程中可能会遇到各种错误和问题,本文将全面探讨createdataset报错的原因、解决方法以及相关FAQs,帮助您更好地理解和解决这些问题。

在数据科学领域,数据集的创建和管理是基础且关键的环节,无论是进行数据分析、机器学习还是深度学习,都需要一个高质量的数据集作为支撑,在实际操作过程中,我们可能会遇到各种报错信息,如“createdataset报错”,这些错误可能源于多种原因,如数据格式不正确、依赖库缺失或代码逻辑错误等,为了帮助大家更好地理解和解决这些问题,本文将详细分析createdataset报错的原因、提供解决方案,并列举相关FAQs。

二、createdataset报错的原因及解决方法

1、数据格式不正确

(1)原因:输入的数据格式不符合预期,例如CSV文件的分隔符错误、JSON文件的结构不正确等。

(2)解决方法:检查数据文件的格式,确保与代码中的预期格式一致,可以使用文本编辑器或专门的数据查看工具来检查数据文件。

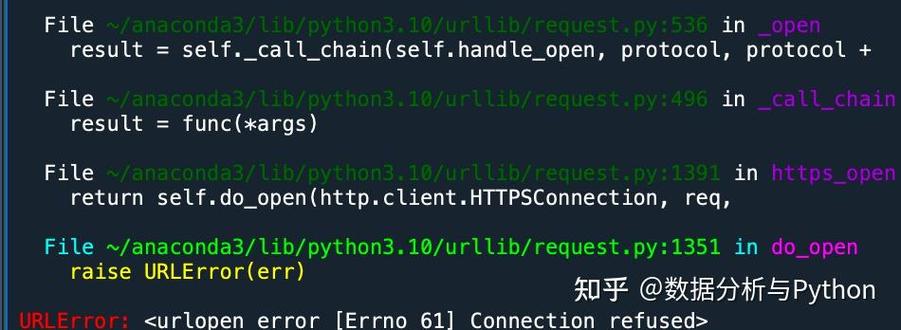

2、依赖库缺失或版本不兼容

(1)原因:代码中使用了某些第三方库,但这些库没有安装或版本不兼容。

(2)解决方法:检查代码中引用的第三方库,确保它们已经正确安装且版本兼容,可以使用pip或conda等包管理工具来安装或更新这些库。

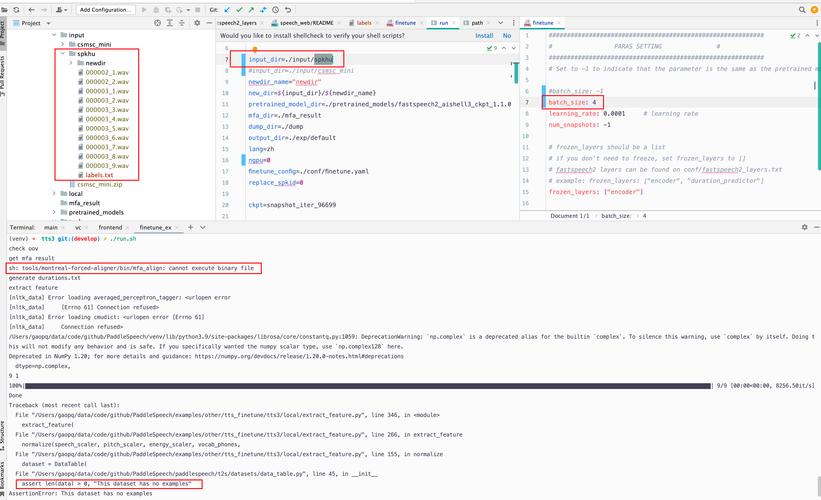

3、代码逻辑错误

(1)原因:代码中的逻辑错误可能导致createdataset函数无法正确执行。

(2)解决方法:仔细检查代码逻辑,确保没有语法错误或逻辑漏洞,可以逐步调试代码,或者使用断点调试器来定位问题所在。

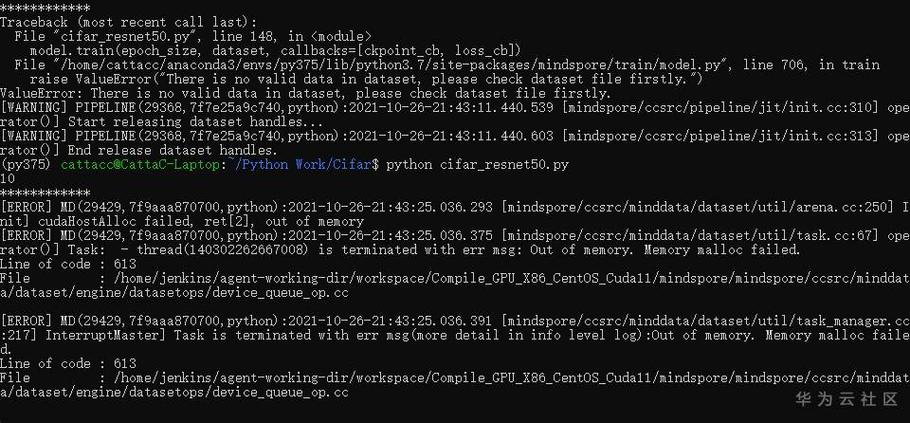

4、内存不足

(1)原因:当数据集过大时,可能会导致内存不足,从而引发createdataset报错。

(2)解决方法:优化代码以减少内存占用,或者使用更强大的计算资源,如果可能的话,可以尝试对数据集进行分块处理或使用分布式计算框架来处理大规模数据。

相关FAQs

1、Q: 我在运行createdataset函数时遇到了“ModuleNotFoundError: No module named 'pandas'”的错误,应该怎么办?

A: 这个错误表示您的环境中缺少pandas库,您需要使用pip install pandas命令来安装pandas库,如果您使用的是Jupyter Notebook或其他IDE,请确保在相应的环境中安装了pandas库。

2、Q: 我有一个非常大的数据集,每次运行createdataset函数都会因为内存不足而失败,有什么解决办法吗?

A: 对于大规模数据集,您可以尝试以下方法来解决这个问题:

优化代码以减少内存占用,例如使用生成器表达式或迭代器来处理数据。

对数据集进行分块处理,每次只加载一部分数据进行处理。

使用分布式计算框架(如apache Spark)来处理大规模数据。

增加计算资源的内存容量,例如升级服务器或使用云服务提供的更多内存实例。