解决Anaconda连接Hive的常见报错指南

作为数据分析师或工程师,在Anaconda环境中尝试连接Hive进行数据操作时遭遇报错,是令人沮丧的体验,频繁出现的错误信息不仅打断工作流,更消耗宝贵时间,结合实践经验,梳理了最常见的连接问题及其解决方案:

PyHive依赖冲突:版本不兼容陷阱

- 典型报错:

thriftpy2.transport.base.TTransportException: TTransportException(type=1, message="Could not start SASL: b'Error in sasl_client_start (-4) SASL(-4): no mechanism available: Unable to find a callback: 2'")或涉及org.apache.thrift.transport.TTransportException的错误。 - 核心原因: PyHive 依赖的底层 Thrift 库版本与集群环境中的 HiveServer2 或 Hadoop 安全认证机制不兼容。

- 解决步骤:

- 确认环境: 登录Hive集群节点,检查HiveServer2版本 (

hive --version) 及Hadoop版本 (hadoop version),重点确认集群是否启用Kerberos或SASL认证。 - 清理与降级: 在Anaconda环境中执行:

pip uninstall -y pyhive thrift thrift-sasl sasl pip install "pyhive[hive]" pip install thrift==0.13.0 # 或尝试0.10.0、0.16.0等稳定版本 pip install thrift-sasl==0.4.3 # SASL认证关键依赖

thrift==0.13.0+thrift-sasl==0.4.3组合兼容性较好,若报错提及sasl,额外安装pip install sasl。 - 验证依赖链:

pip show pyhive thrift thrift-sasl sasl确保版本符合预期。

- 确认环境: 登录Hive集群节点,检查HiveServer2版本 (

SASL/GSSAPI 认证失败:Kerberos配置关键点

- 典型报错:

sasl.SaslException: Error in sasl_client_start (-1) SASL(-1): generic failure: GSSAPI Error: Unspecified GSS failure. Minor code may provide more information (Server not found in Kerberos database)或包含GSSAPI、Kerberos、SASL ERROR。 - 核心原因: Kerberos票据问题或客户端配置缺失。

- 解决步骤:

- 获取有效票据:

kinit -kt /path/to/your/keytab.service.keytab your_principal@YOUR.REALM # 使用keytab # 或 kinit your_principal@YOUR.REALM # 交互式输入密码 klist # 验证票据存在且有效

- 检查Kerberos配置: 确保 Anaconda 所在机器的

/etc/krb5.conf文件正确指向 KDC 服务器和 Realm 信息,与集群配置一致。 - 配置Hive连接参数: 在Python连接代码中显式传递认证机制和principal:

from pyhive import hive conn = hive.Connection( host='your-hiveserver2-host', port=10000, auth='KERBEROS', # 或 'NOSASL' 如果集群禁用 kerberos_service_name='hive', # 通常为 'hive' configuration={'hive.server2.proxy.user': 'your_impersonate_user'} # 如有代理需求 ) - 检查服务Principal: 错误信息中的

Server not found...通常意味着连接指定的主机名(如hiveserver2.your.domain)未在 KDC 中注册对应的hiveservice principal (hive/hiveserver2.your.domain@YOUR.REALM),需联系集群管理员确认。

- 获取有效票据:

HiveServer2配置与服务可达性

- 典型报错:

TTransportException: Could not connect to your-hiveserver2-host:10000或Failed to open new session: java.lang.RuntimeException: org.apache.hadoop.ipc.RemoteException(org.apache.hadoop.security.authorize.AuthorizationException)...。 - 核心原因: HiveServer2未运行、网络不通、端口错误或客户端用户权限不足。

- 解决步骤:

- 服务状态检查: 在HiveServer2节点执行

netstat -tuln | grep 10000确认端口监听正常,通过集群管理界面或ps -ef | grep hive检查服务进程。 - 网络连通性: 在Anaconda环境所在机器执行

telnet your-hiveserver2-host 10000或nc -zv your-hiveserver2-host 10000,失败则检查防火墙、安全组规则。 - 用户代理/模拟: 如果连接代码使用了

hive.server2.proxy.user,需确保发起连接的用户(即执行kinit的用户)拥有代理权限(在hadoop.proxyuser.$superuser.groups/hosts配置中)。 - 核心配置文件: 检查集群端

hive-site.xml:hive.server2.thrift.port(默认10000)hive.server2.authentication(KERBEROS,NONE,LDAP等)hive.server2.thrift.bind.host(确保绑定正确接口)hive.server2.enable.doAs(是否启用代理)

- 服务状态检查: 在HiveServer2节点执行

操作系统环境依赖缺失

- 典型报错: 与

libsasl2或gssapi相关的动态链接库缺失错误 (如ImportError: /lib64/libsasl2.so.3: undefined symbol: EVP_md2, version OPENSSL_1_1_0)。 - 核心原因: Anaconda环境缺少必要的系统级SASL或Kerberos库。

- 解决步骤:

- 安装系统包: 根据操作系统安装:

- CentOS/RHEL:

sudo yum install cyrus-sasl-gssapi cyrus-sasl-devel krb5-devel krb5-workstation openssl-devel - Ubuntu/Debian:

sudo apt-get install libsasl2-dev libsasl2-modules-gssapi-mit krb5-user libkrb5-dev

- CentOS/RHEL:

- 重建Python依赖: 安装系统包后,在Anaconda环境中重新安装

thrift-sasl和sasl:pip uninstall thrift-sasl sasl pip install thrift-sasl sasl

- 检查库路径: 确保系统库路径 (如

/usr/lib64,/usr/lib) 包含在环境变量LD_LIBRARY_PATH中(尤其是在非标准路径安装时)。

- 安装系统包: 根据操作系统安装:

SSL/TLS 证书问题

- 典型报错:

[SSL: CERTIFICATE_VERIFY_FAILED] certificate verify failed: unable to get local issuer certificate (_ssl.c:1129)或TSocket read 0 bytes(可能与SSL握手失败有关)。 - 核心原因: HiveServer2启用了SSL,但客户端缺少信任的CA证书或未启用SSL连接。

- 解决步骤:

- 确认SSL状态: 检查集群

hive-site.xml中的hive.server2.use.SSL(应为true)。 - 获取信任证书: 从集群管理员处获取HiveServer2使用的CA证书(或服务器证书链)。

- 配置连接信任:

- 将CA证书添加到操作系统的全局信任库(需管理员权限)。

- 在Python连接代码中指定证书路径(如果PyHive支持,有时需在

configuration中传递特定参数,或使用requests的verify参数变通)。 - 方法三(不推荐,测试用): 在连接参数中禁用证书验证(存在安全风险):

import ssl from pyhive import hive ssl_context = ssl.create_default_context() ssl_context.check_hostname = False ssl_context.verify_mode = ssl.CERT_NONE conn = hive.Connection(..., ssl_context=ssl_context)

- 确认SSL状态: 检查集群

调试核心原则:精准定位错误根源

面对Anaconda连接Hive的报错,关键在于逐层剥离、精准定位,盲目尝试解决方案往往徒劳无功,务必养成习惯:

- 细读错误信息: 错误日志的第一行和最后几行通常包含最关键信息(如错误类型、异常类名、错误码),将完整的堆栈信息复制出来仔细分析。

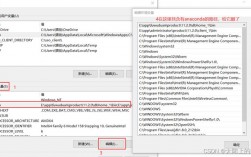

- 对比环境配置: 明确本地Anaconda环境(Python版本、PyHive/thrift/thrift-sasl/sasl版本)与目标Hive集群环境(Hive/Hadoop版本、安全机制、核心配置项)的差异,版本兼容性往往是首要怀疑点。

- 分步验证网络与基础服务: 先确保最基本的网络可达性(ping, telnet/nc到端口)和Kerberos票据有效性(klist)通过,再深入到应用层连接。

- 利用集群日志: 客户端报错信息有限时,查看HiveServer2服务端的日志(通常位于

/var/log/hive/或集群日志管理界面)至关重要,服务端日志通常会提供更详细的错误原因(如认证失败的具体用户、权限问题细节)。

连接问题本质上是环境一致性、协议兼容性和安全配置的交汇点,耐心检查每一环节的匹配性,结合清晰的错误日志和集群文档,大部分障碍都能被有效排除,掌握系统的调试方法,远比记忆零散的解决方案更能应对复杂多变的实际环境。

观点: 在数据工程实践中,连接器报错是常态而非例外,耐心阅读错误信息、理解组件交互原理、版本兼容矩阵和集群安全策略,才是高效解决问题的核心能力,依赖碎片化的解决方案往往事倍功半。