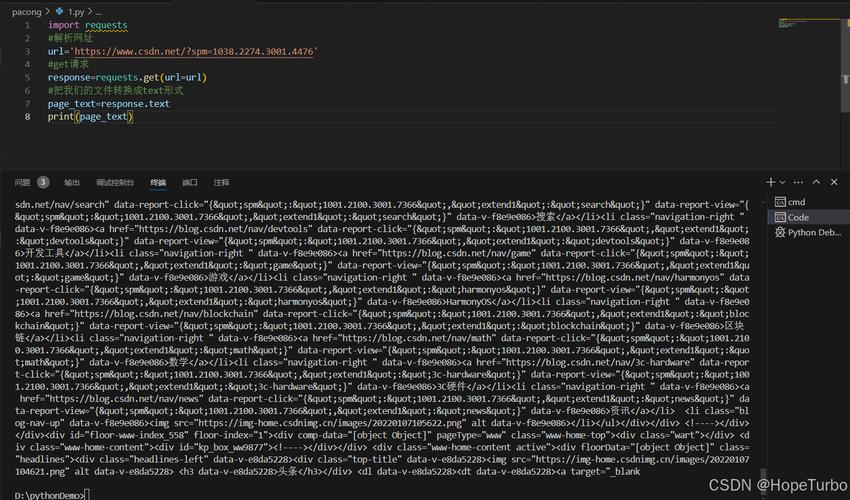

在使用Python进行网络爬虫开发时,requests库无疑是开发者最常用的工具之一,它简洁的接口和强大的功能使得发送HTTP请求变得十分便捷,即便是经验丰富的开发者,也难免会在使用过程中遇到各种报错,这些错误信息往往看似晦涩,但背后隐藏的问题却值得深入分析。

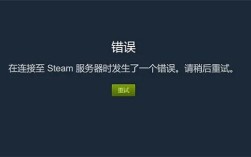

常见的一个错误是连接超时(Connection Timeout),这类错误通常表现为ConnectTimeout或ReadTimeout异常,出现这种情况,可能是因为目标服务器响应过慢,或者网络环境不稳定,在代码中设置了过短的超时时间,而服务器未能在此时间内响应,便会触发此类错误,解决方法是适当增加超时时间,或者通过重试机制来处理暂时性的网络问题。

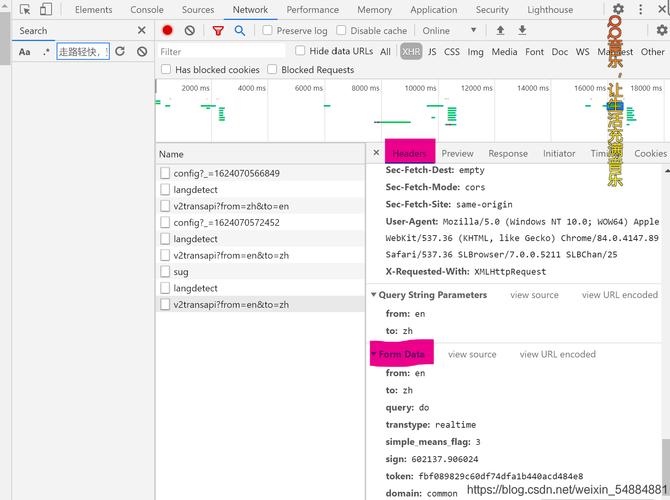

另一个常见问题是HTTP错误,例如HTTP 404 Not Found或HTTP 403 Forbidden,这类错误表明请求的资源不存在或服务器拒绝访问,对于404错误,通常需要检查请求的URL是否正确;而对于403错误,则可能是因为目标网站设置了反爬虫机制,例如验证User-Agent或IP频率限制,可以通过模拟浏览器头部信息或使用代理IP来规避限制。

SSL证书验证失败也是一个常见的报错,在使用HTTPS协议时,如果服务器的SSL证书无效或未被信任,requests会抛出SSLError,为了避免这一问题,可以在请求中设置verify=False参数,但需要注意的是,这样做会降低安全性,仅建议在测试环境中使用,在生产环境中,应确保使用有效的证书。

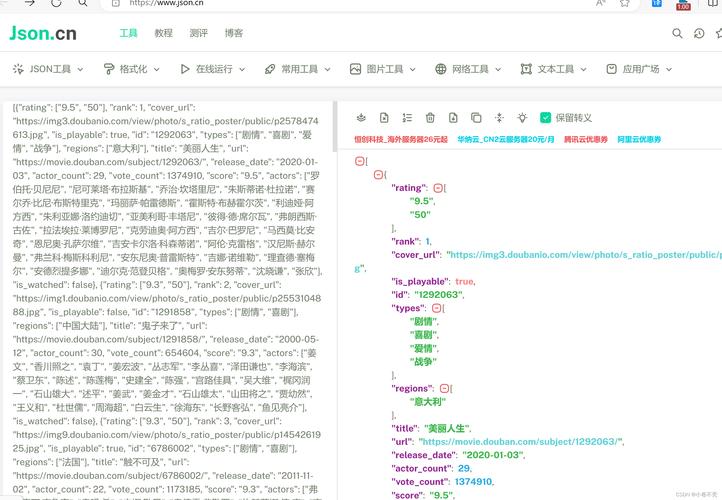

还有一种错误是编码问题,有时获取的网页内容出现乱码,可能是因为响应内容的编码与requests库自动检测的编码不一致,可以手动指定编码方式,例如通过response.encoding = 'utf-8'来强制使用UTF-8编码,确保文本内容正确解析。

除了上述常见错误,还有一些较为复杂的情况,例如代理设置错误或Cookie处理不当,代理错误可能导致请求无法发送,而Cookie问题则可能使得会话状态无法保持,对于代理,需要确保代理服务器的地址和端口正确,且代理本身可用;对于Cookie,则可以通过Session对象来管理,确保多次请求之间的状态一致性。

在实际开发中,处理这些错误不仅需要理解其产生的原因,还需要具备一定的调试能力,通过打印响应状态码、头部信息或内容摘要,可以帮助快速定位问题,使用try-except结构捕获异常,并结合日志记录,能够提升程序的健壮性。

需要注意的是,虽然requests库功能强大,但在面对复杂的反爬机制时,仍可能显得力不从心,一些网站会通过JavaScript动态加载内容,或使用验证码来阻止自动化访问,在这种情况下,仅靠requests可能无法完成任务,需要借助Selenium或Puppeteer等工具来模拟浏览器行为。

从开发者的角度来看,遇到报错并不可怕,关键是如何系统地分析和解决这些问题,应仔细阅读错误信息,理解其含义;通过查阅文档或社区讨论,寻找类似问题的解决方案;通过代码调整和测试,验证解决方法的有效性,这一过程不仅能够提升技术水平,还能培养解决问题的能力。

个人认为,掌握requests库的错误处理技巧,是每一个爬虫开发者的基本功,只有深入理解HTTP协议和网络通信的原理,才能在实际项目中游刃有余,保持良好的编码习惯,例如使用异常处理和日志记录,能够显著提高代码的可靠性和可维护性。