编码方式的基础概念

在操作系统中,编码方式决定了字符如何以二进制形式存储和传输,CentOS作为企业级Linux发行版,默认采用UTF-8编码标准,UTF-8兼容ASCII,同时支持多语言字符集,适合全球化应用场景,理解编码机制,能帮助用户避免文件乱码、程序兼容性等问题。

为什么需要关注编码?

开发者和运维人员常遇到以下场景:

- 从Windows系统传输到Linux服务器的文件出现乱码;

- 终端显示异常符号;

- 日志文件中的中文无法正常解析。

这些问题通常源于编码不统一,Windows默认使用GBK编码,而CentOS默认UTF-8,跨平台传输文件时若未做转换,就会导致乱码。

CentOS中的编码配置

查看系统当前编码

通过locale命令可查看系统语言环境设置:

$ locale LANG=en_US.UTF-8 LC_CTYPE="en_US.UTF-8" LC_ALL=

关键变量为LANG和LC_ALL,若未显式设置,系统可能继承默认值。

修改编码方式

1、临时生效:

在终端输入:

export LANG=zh_CN.UTF-8

此方式仅对当前会话有效,重启后失效。

2、永久生效:

编辑配置文件/etc/locale.conf:

LANG=zh_CN.UTF-8 LC_ALL=zh_CN.UTF-8

保存后执行source /etc/locale.conf或重启系统。

常见编码问题与解决方案

场景1:SSH连接显示乱码

部分SSH客户端(如PuTTY)默认字符集为ISO-8859-1,与服务器UTF-8不匹配。

解决方法:

- 调整客户端编码为UTF-8;

- 在CentOS中安装中文字体包:

yum groupinstall "Fonts"

使用file命令检测文件编码:

$ file -i filename.txt filename.txt: text/plain; charset=iso-8859-1

若文件编码为GBK或ISO-8859-1,可用iconv转换:

iconv -f GBK -t UTF-8 filename.txt > newfile.txt

场景3:日志中的中文乱码

应用程序(如Nginx、MySQL)若未明确指定编码,可能使用系统默认值。

配置示例(以Nginx为例):

http {

charset utf-8;

...

}编码最佳实践

1、统一环境编码:

开发、测试、生产环境应使用相同的编码标准(推荐UTF-8)。

2、谨慎处理文件传输:

跨平台传输时,使用工具如dos2unix清除Windows换行符,并用iconv转换编码。

3、验证应用程序配置:

检查数据库、Web服务器等关键服务的字符集设置,确保与系统一致。

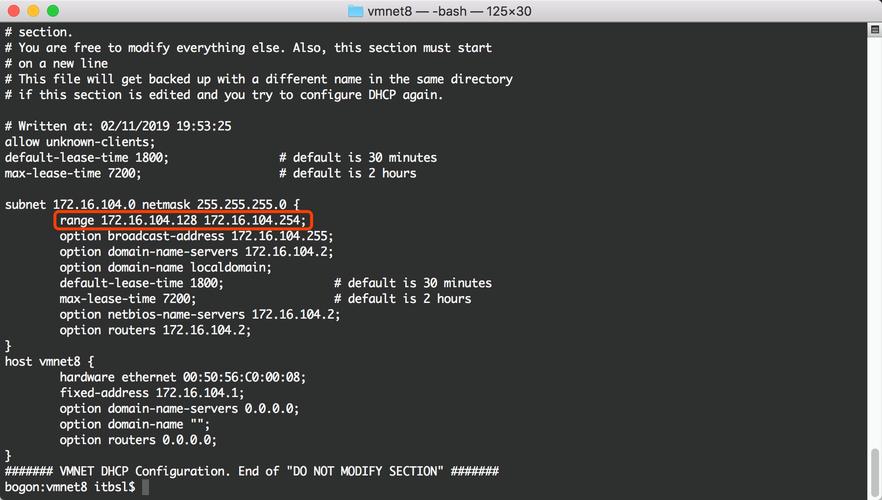

4、终端工具适配:

选择支持UTF-8的终端工具(如MobaXterm或SecureCRT),并关闭“自动检测编码”功能。

个人观点

编码问题看似琐碎,却直接影响系统稳定性和用户体验,尤其在多语言项目中,UTF-8几乎是唯一可行的选择,运维人员需养成习惯:部署新环境时,优先确认编码设置;遇到乱码时,从文件、传输工具、应用程序三方面排查,定期备份关键配置文件(如locale.conf),可减少人为误操作带来的风险。