在CentOS上部署Hadoop是一个复杂但非常有意义的过程,尤其对于需要大数据处理和分析的环境,以下是详细的步骤和注意事项,以确保整个过程顺利进行:

准备工作

1、安装CentOS:确保你已经安装了CentOS 7操作系统,你可以通过虚拟机或物理机进行安装,如果使用虚拟机,建议克隆多个虚拟机以便后续集群的搭建。

2、查看和配置IP地址:安装完成后,进入系统并查看当前网络配置,使用以下命令检查IP地址:

```bash

ifconfig

```

根据需要进行静态IP地址配置,编辑/etc/sysconfig/networkscripts/ifcfgens33文件,设置静态IP、子网掩码和网关。

二、安装Java Development Kit (JDK)

Hadoop依赖JDK运行,因此需要先安装JDK,以下是具体步骤:

1、下载JDK:从Oracle官方网站或其他可信来源下载适合的JDK版本。

2、解压并配置环境变量:

```bash

tar zxvf jdk8uXXXlinuxx64.tar.gz C /usr/local

```

编辑/etc/profile文件,添加以下内容:

```bash

export JAVA_HOME=/usr/local/jdk1.8.0_XXX

export PATH=$PATH:$JAVA_HOME/bin

export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

```

使配置生效:

```bash

source /etc/profile

```

下载并安装Hadoop

1、下载Hadoop:从Apache Hadoop官网或其他可信来源下载Hadoop压缩包(例如hadoop3.3.3.tar.gz)。

2、解压Hadoop:

```bash

tar zxvf hadoop3.3.3.tar.gz C /usr/local

```

将解压后的文件夹移动到合适的位置,如/usr/local/hadoop。

3、配置Hadoop环境变量:编辑/etc/profile文件,添加以下内容:

```bash

export HADOOP_HOME=/usr/local/hadoop

export PATH=$PATH:$HADOOP_HOME/bin

```

使配置生效:

```bash

source /etc/profile

```

配置Hadoop

1、配置coresite.xml:编辑$HADOOP_HOME/etc/hadoop/coresite.xml文件,添加以下内容:

```xml

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

```

2、配置hdfssite.xml:编辑$HADOOP_HOME/etc/hadoop/hdfssite.xml文件,添加以下内容:

```xml

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:///usr/local/hadoop/hadoop_data/hdfs/namenode</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:///usr/local/hadoop/hadoop_data/hdfs/datanode</value>

</property>

</configuration>

```

3、配置mapredsite.xml:编辑$HADOOP_HOME/etc/hadoop/mapredsite.xml文件,添加以下内容:

```xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

```

4、配置yarnsite.xml:编辑$HADOOP_HOME/etc/hadoop/yarnsite.xml文件,添加以下内容:

```xml

<configuration>

<property>

<name>yarn.nodemanager.auxservices</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>localhost</value>

</property>

</configuration>

```

5、格式化NameNode:在第一次启动Hadoop之前,需要格式化NameNode:

```bash

hdfs namenode format

```

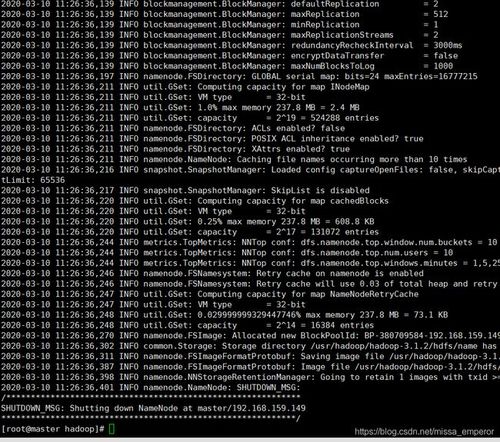

启动Hadoop

1、启动HDFS:

```bash

startdfs.sh

```

2、启动YARN:

```bash

startyarn.sh

```

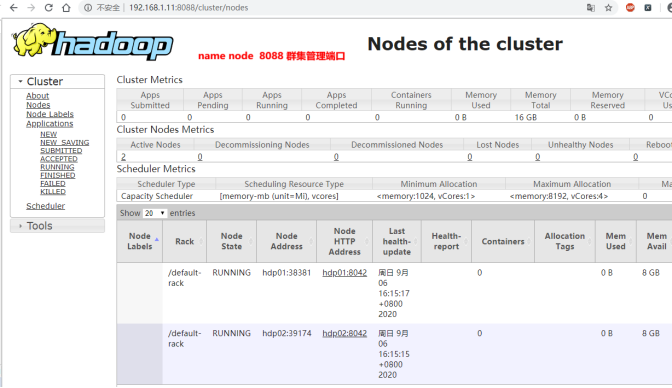

3、验证Hadoop安装:通过访问Web界面验证Hadoop是否正常运行,默认情况下,NameNode的Web界面位于http://localhost:9870,ResourceManager的Web界面位于http://localhost:8088。

常见问题及解决方法

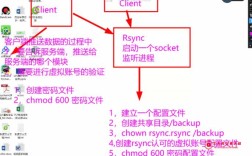

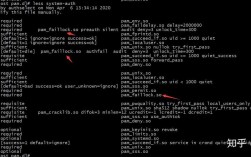

1、权限问题:确保所有配置文件和目录具有适当的权限,你可以使用chmod和chown命令调整权限。

2、端口冲突:如果系统中其他服务占用了Hadoop所需的端口,可以修改配置文件中的端口号。

3、内存不足:如果遇到内存不足的问题,可以增加虚拟机的内存分配或优化Hadoop的配置参数。

相关问答FAQs

1、Q:如何查看Hadoop集群的状态?

A:可以通过访问NameNode和ResourceManager的Web界面来查看集群状态,可以使用Hadoop提供的命令行工具,如hdfs dfsadmin report和yarn node list。

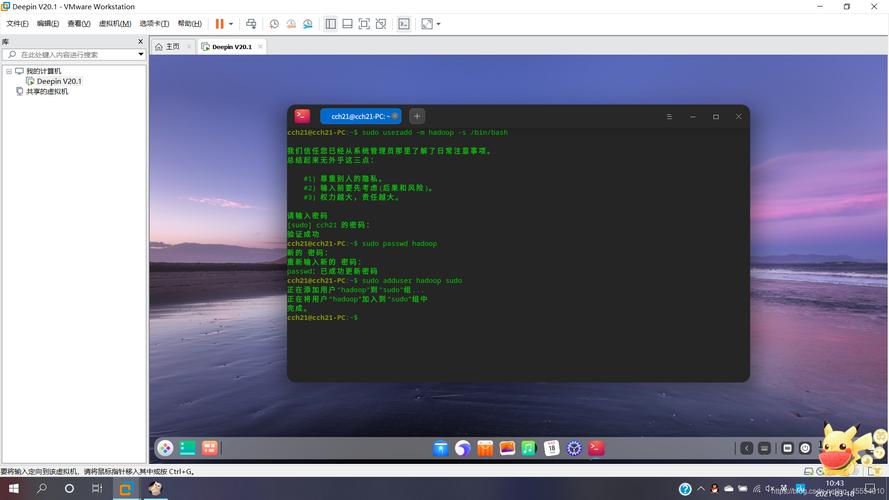

2、Q:如何添加新的节点到Hadoop集群?

A:首先在新节点上重复上述安装和配置步骤,然后在主节点的配置文件中添加新节点的信息,重启Hadoop服务以使更改生效。