排查Solr Data Import异常的核心思路与实践方案

在使用Apache Solr进行数据导入时,"dataimport"功能异常是开发者常遇到的挑战,这类错误不仅影响数据索引效率,还可能直接导致搜索服务中断,本文将针对常见错误场景,结合排查逻辑与修复方案,提供系统性的解决思路。

一、Data Import报错的典型场景

1、配置文件缺失或语法错误

Solr的data-config.xml文件是数据导入的核心配置,当出现"Could not load configuration"提示时,需优先检查以下内容:

- XML标签闭合是否正确(如<entity>嵌套错误)

- 特殊字符未转义(例如&需替换为&)

- 路径参数是否准确(如dataDir指向的绝对路径是否存在)

2、数据库连接失败

若错误提示包含"Communications link failure"或"Access denied",需验证:

- JDBC驱动版本与数据库兼容性(MySQL 8.x需使用mysql-connector-java-8.x.jar)

- 网络策略限制(如数据库防火墙是否开放Solr服务器IP)

- 账号权限是否具备读取目标表的权限

3、数据格式解析异常

日期字段格式不匹配、字符串超长或包含非法字符(如\u0000)可能导致索引中断。

- 数据库中的datetime字段若未配置format="yyyy-MM-dd HH:mm:ss",可能触发类型转换错误

- 文本内容包含HTML标签时,需在data-config.xml中启用stripHTML="true"过滤器

**二、深度排查方法论

**步骤1:日志分析与关键词定位

Solr的日志文件(默认位于server/logs/solr.log)是首要排查入口,建议:

- 使用grep "Full Import" solr.log快速定位最近一次导入记录

- 关注SEVERE或ERROR级别的日志行,提取错误代码(如SQLException)

示例:

ERROR (Thread-15) [ ] o.a.s.h.d.DataImporter Full Import failed:org.apache.solr.handler.dataimport.DataImportHandlerException: java.lang.NumberFormatException: For input string: "123abc"

此日志表明某字段尝试将字符串"123abc"转换为数字类型失败,需检查源数据或调整data-config.xml中的type定义。

**步骤2:增量调试与最小化验证

对于复杂的数据源,建议分阶段验证:

1、注释掉非核心<entity>定义,仅保留主表配置

2、逐步启用关联查询(如JOIN操作),观察是否触发错误

3、使用verbose=true参数输出详细处理过程

**步骤3:内存与性能监控

大规模数据导入时,JVM堆内存不足可能引发OutOfMemoryError,可通过以下方式优化:

- 调整Solr启动参数:-Xms4g -Xmx8g(根据服务器配置动态设置)

- 分批次导入:在data-config.xml中配置batchSize="5000"限制单次读取行数

**三、高频问题解决方案

场景1:多表关联导致的数据重复

问题现象

使用JOIN语句导入关联表数据时,出现重复文档。

修复方案

- 在根<document>标签下设置name唯一标识:

<entity name="order" query="SELECT id, user_id FROM orders">

<field column="id" name="id" />

<entity name="user" query="SELECT name FROM users WHERE id='${order.user_id}'">

<field column="name" name="user_name" />

</entity>

</entity>- 添加distinct="true"参数避免重复记录

场景2:时区不一致导致时间戳错误

问题现象

数据库与Solr服务器时区不同,导致索引时间字段偏差。

修复方案

- 在JDBC URL中强制指定时区:

jdbc:mysql://localhost:3306/db?serverTimezone=UTC

- 在data-config.xml中转换时区:

<field column="create_time" type="date" dateTimeFormat="yyyy-MM-dd HH:mm:ss" locale="en" timeZone="UTC" />

**四、长期优化策略

1、预检脚本自动化

编写Shell脚本,在每次导入前自动校验:

- 数据库连接是否正常(通过nc -zv db_host 3306)

- 配置文件语法(使用xmllint --valid data-config.xml)

2、异常数据隔离机制

在ETL流程中增加脏数据捕获环节:

- 使用try-catch块记录解析失败的数据行

- 将错误数据写入日志或临时表供后续分析

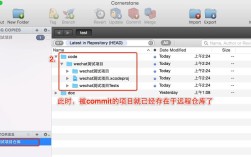

3、版本控制与回滚

对data-config.xml和Schema文件实施Git版本管理,确保每次变更可追溯。

作为长期与Solr打交道的开发者,我认为数据导入问题往往源于“细节疏忽”,一个未被转义的换行符可能导致整个导入任务失败,建议开发者养成两个习惯:一是在每次修改配置后执行curl http://solr:8983/solr/core-name/dataimport?command=reload-config重载配置;二是对复杂查询使用dataimport的debug模式逐字段验证输出结果,技术的稳定性,本质上是对细节的持续把控。