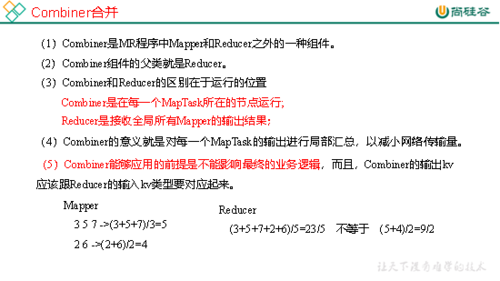

在使用Hadoop MapReduce进行数据处理时,setCombinerClass方法用于设置Combiner类,Combiner是MapReduce框架中的一个优化工具,它的作用是在Map阶段结束后、Reduce阶段开始前对Map的输出进行局部汇总,从而减少网络传输的数据量和Reduce阶段的计算压力,在实际应用中,使用setCombinerClass可能会遇到一些报错问题,下面将详细分析这些报错的原因及其解决方案。

常见报错及解决方案

| 报错信息 | 原因分析 | 解决方案 |

ClassNotFoundException | Combiner类未找到,可能是由于类路径(classpath)配置不正确,或者该类没有编译到JAR包中。 | 确保Combiner类已经正确编译并包含在JAR包中,同时确保Hadoop作业的classpath包含了该JAR包。 |

IllegalArgumentException | 传递给setCombinerClass的参数不是有效的类名,或者该类没有实现必要的接口。 | 确保传递给setCombinerClass的是一个有效的Java类名,并且这个类实现了Reducer接口。 |

NullPointerException | Combiner类的实例化过程中发生了空指针异常,可能是Combiner类中使用了未初始化的对象。 | 检查Combiner类的代码,确保所有对象在使用前都已正确初始化。 |

VerifyError | 类文件格式错误或版本不兼容,可能是使用了不同版本的编译器或运行时环境。 | 确保使用相同版本的Java编译器和运行时环境来编译和运行MapReduce作业。 |

IncompatibleClassChangeError | Combiner类与Hadoop API版本不兼容,可能是API发生了变化,但代码没有相应更新。 | 检查Hadoop API文档,确保Combiner类符合当前API版本的要求,必要时更新代码以适配新的API。 |

深入解析

1、确保类路径正确:

当出现ClassNotFoundException时,首先需要检查的是类路径是否正确,这包括确认所有的依赖库都已正确添加到classpath中,以及确保Hadoop作业的配置中包含了正确的JAR包路径,可以通过以下方式添加JAR包到classpath:

```xml

<property>

<name>mapreduce.job.classpath.jars</name>

<value>/path/to/your/jarfile.jar</value>

</property>

```

2、验证Combiner类的正确性:

如果报错信息为IllegalArgumentException,需要验证Combiner类的有效性,确保该类实现了Reducer接口,并且构造函数是可访问的(通常是public),还需要确保该类的reduce方法签名与Reducer接口中定义的一致。

3、处理空指针异常:

对于NullPointerException,需要仔细检查Combiner类的实现,特别是那些涉及到对象操作的部分,确保所有对象在使用之前都已被正确初始化,如果Combiner类中使用了某个辅助类的成员变量,那么在构造函数中就需要对其进行初始化。

4、解决版本兼容性问题:

如果遇到VerifyError或IncompatibleClassChangeError,可能是因为Hadoop的版本与Combiner类编写时使用的API版本不一致,这种情况下,需要查看Hadoop的官方文档,了解API的变化,并根据最新的API更新Combiner类的代码,确保使用相同版本的Java编译器和Hadoop运行时环境。

FAQs

Q1: 如果我已经确认Combiner类在JAR包中,但仍然收到ClassNotFoundException,我应该怎么办?

A1: 如果你确定Combiner类已经被打包到JAR文件中,但仍然遇到ClassNotFoundException,请检查Hadoop作业的配置是否正确加载了JAR包,你可以尝试在Hadoop命令行中使用libjars选项显式指定JAR包的路径,

- hadoop jar yourJob.jar YourMainClass libjars /path/to/your/jarfile.jar

Q2: 如何确保我的Combiner类与当前的Hadoop API版本兼容?

A2: 要确保Combiner类与当前的Hadoop API版本兼容,你可以采取以下步骤:

1、查阅Hadoop的官方文档,了解任何可能影响你的Combiner类的API变更。

2、阅读Hadoop的发布说明,特别关注与你使用的Hadoop版本相关的部分。

3、如果有必要,更新你的Combiner类以适应API的变化。

4、在本地环境中使用相同的Hadoop版本测试你的Combiner类,以确保一切正常工作。

5、考虑使用Maven或其他构建工具来管理依赖关系和构建过程,这样可以更容易地保持代码与依赖库的兼容性。