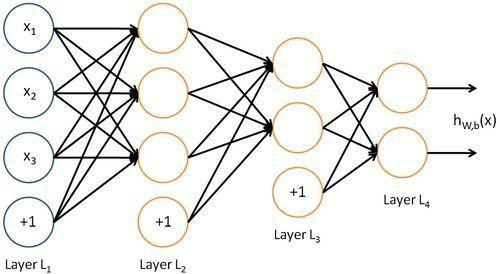

CUDNN RNN 报错问题在深度学习和神经网络训练中是一个常见的问题,尤其在使用 TensorFlow 框架时,cuDNN(CUDA Deep Neural Network library)是NVIDIA开发的一个用于加速深度学习的GPU库,可以显著提升模型训练和推理的速度,由于其复杂的配置和使用方式,常常会导致一些错误。

以下是对cudnnrnn报错的详细分析:

1、版本不匹配问题

cuDNN 与 TensorFlow 版本不匹配:cuDNN 库的版本与 TensorFlow 框架的版本不兼容,可能会导致各种错误,cuDNN 7.3.1 版本与编译时使用的 cuDNN 7.6.5 版本不一致,可能会引发错误。

解决方案:确保安装的 cuDNN 版本与 TensorFlow 版本兼容,可以通过访问 [NVIDIA官方网站](https://developer.nvidia.com/cudnn) 下载对应版本的 cuDNN。

2、显存不足问题

显存不足导致的错误:当 GPU 显存不足以支持当前任务时,会出现如 "could not create cudnn handle: CUDNN_STATUS_INTERNAL_ERROR" 或 "TypeError: Fail to find the dnn implementation" 等错误。

解决方案:可以通过调整 TensorFlow 的显存分配策略来缓解此问题,设置 TensorFlow 在需要时逐步分配显存,而不是一开始就占用所有显存,具体代码如下:

import os

os.environ["TF_FORCE_GPU_ALLOW_GROWTH"] = "true"3、模型结构问题

直接保存和加载模型的问题:如果在 CPU 上直接保存和加载包含 CudnnRNN 层的模型,会因为该层依赖于 GPU 而无法执行。

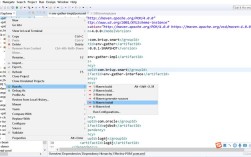

解决方案:在保存和加载模型时,需要使用兼容的模型结构和层,可以在 GPU 上训练模型并保存检查点,然后在兼容的模型图里面加载这些检查点,具体实现方法如下:

from tensorflow.keras.layers import Bidirectional, CuDNNLSTM, LSTM

def rnn_layer(self, rnn_inputs, hidden_size, sequence_lengths, name=None):

if self.use_gpu:

layer = Bidirectional(CuDNNLSTM(hidden_size, return_sequences=True))

else:

layer = Bidirectional(LSTM(hidden_size, activation='tanh', recurrent_activation='sigmoid', return_sequences=True))

output = layer(rnn_inputs)4、配置错误问题

GPU 配置错误:在使用多 GPU 进行训练时,可能会出现 GPU 内存不平衡的问题,这会导致训练过程中的错误。

解决方案:在代码中显式地设置设备 ID,以确保每个 GPU 的内存和资源得到合理分配,可以使用tf.distribute.Strategy 来实现这一点。

strategy = tf.distribute.MirroredStrategy()

with strategy.scope():

# Define and compile your model here为了进一步帮助理解和解决这些问题,以下是两个常见问题及其解答:

1、为什么在 CPU 上加载包含 CudnnRNN 层的模型会报错?

回答:CudnnRNN 是一个专门为 GPU 优化的层,它依赖于 GPU 来执行计算,如果在 CPU 上直接加载包含 CudnnRNN 层的模型,会因为该层无法在 CPU 上执行而报错,解决方法是在保存和加载模型时使用兼容的模型结构和层。

2、如何解决显存不足导致的 CudnnRNN 报错?

回答:显存不足问题可以通过调整 TensorFlow 的显存分配策略来解决,设置 TensorFlow 在需要时逐步分配显存,而不是一开始就占用所有显存,具体代码如下:

import os

os.environ["TF_FORCE_GPU_ALLOW_GROWTH"] = "true"通过以上分析和解决方案,可以帮助用户更好地理解和解决 cuDNN RNN 报错问题,从而提升深度学习模型的训练和推理效率。