CentOS 安装 Spark:新手小白的福音

嘿,小伙伴们!👋 你是否曾听说过大数据、分布式计算这些高大上的名词?🤔 是不是觉得它们离我们很远,只有那些技术大牛才能玩转?别怕,今天我就来教大家如何在 CentOS 上安装 Spark,让你也能轻松踏入大数据的世界!🚀

一、为啥要装 Spark?🤔

先来聊聊,为啥我们要在 CentOS 上装 Spark 呢?Spark 是一个超级强大的分布式计算框架,它能帮你快速处理海量数据,想象一下,如果你有一堆照片需要分类,或者要分析用户行为数据,Spark 就能派上用场了,它能让你事半功倍!💪

二、准备工作:环境搭建🛠️

在开始之前,我们得先准备好环境,CentOS 作为一款稳定且流行的 Linux 发行版,是安装 Spark 的好选择,确保你的系统已经更新到最新版本,这样可以避免一些不必要的麻烦。🔧

1、更新系统:打开终端,输入sudo yum update,然后回车,等待系统自动更新。

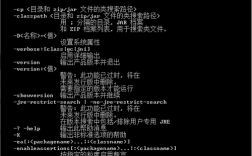

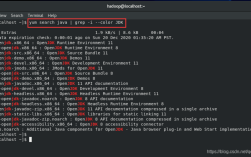

2、安装 Java:Spark 是基于 Java 的,所以你需要先安装 Java,输入sudo yum install java1.8.0openjdkdevel,回车确认。

三、下载与解压 Spark📦

就是下载 Spark 的大戏了!🎉 前往 Apache Spark 的官网(https://spark.apache.org/downloads.html),找到最新版的下载链接,记得选预编译好的二进制包,这样就不用自己编译了,省时省力!💡

下载完成后,用wget 命令把 Spark 下载到本地,比如我下载的是spark3.4.0binhadoop3.tgz,就在终端里输入:

wget https://downloads.apache.org/spark/spark3.4.0/spark3.4.0binhadoop3.tgz

下载好后,用tar 命令解压到你想放的地方,比如/opt 目录:

tar xvf spark3.4.0binhadoop3.tgz C /opt

四、配置 Spark🔧

解压完成后,我们就可以开始配置 Spark 了,主要需要修改两个文件:sparkenv.sh 和slaves。

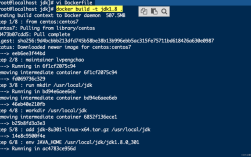

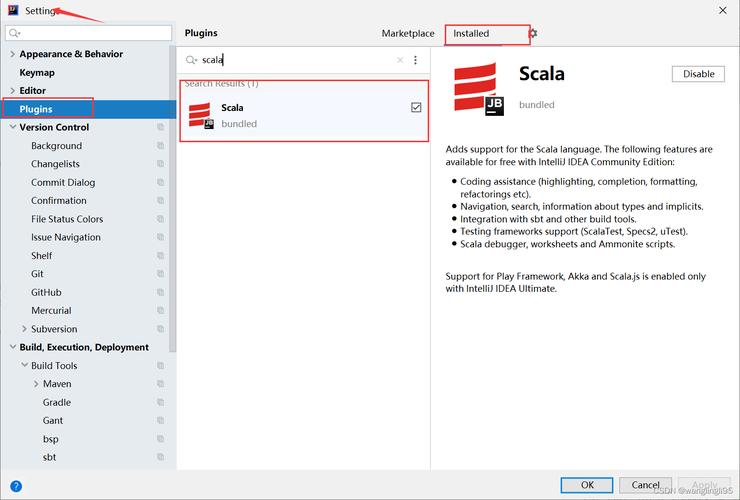

1、配置sparkenv.sh:这个文件用来设置 Spark 的环境变量,打开它(用你喜欢的文本编辑器),找到并修改以下几行:

SPARK_MASTER_HOST:设置为你的 Master 节点的主机名或 IP 地址,如果是单节点部署,就写localhost。

JAVA_HOME:指向你刚才安装的 Java 路径,比如/usr/lib/jvm/java1.8.0openjdk。

2、配置slaves:这个文件列出了所有参与计算的节点,如果是单节点,就写localhost;如果有多个节点,就逐行写上每个节点的主机名或 IP 地址。

五、启动 Spark🔥

一切准备就绪后,就可以启动 Spark 了!先进入 Spark 的安装目录,然后运行:

./sbin/startall.sh

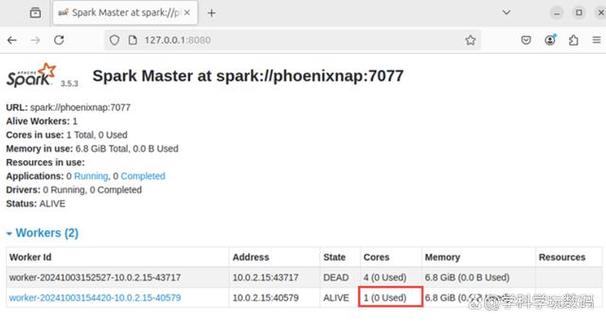

这条命令会同时启动 Master 和 Workers,你可以在浏览器里访问 http://Master_IP:8080 来查看集群状态,是不是很酷?😎

六、简单测试:跑个 WordCount📊

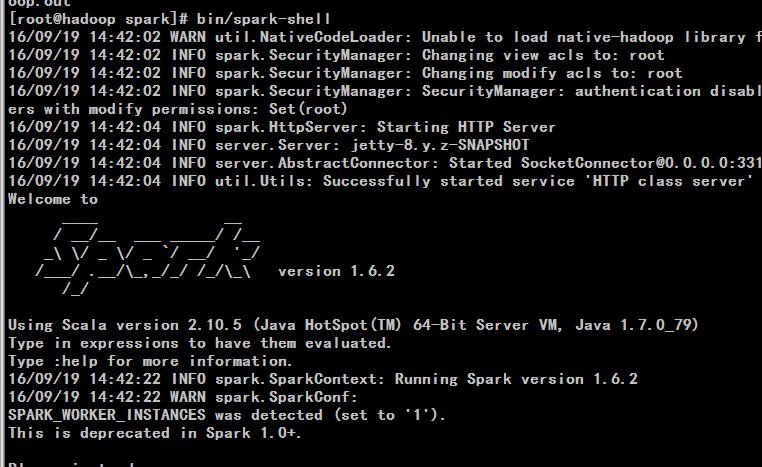

为了验证 Spark 是否安装成功,我们来跑个简单的 WordCount 程序吧!在 Spark 的bin 目录下,有个runexample 脚本,可以用来运行示例程序,我们来试试 WordCount:

./runexample SparkPi 10

这条命令会启动一个 Spark 作业,计算 Pi 的小数点后 10 位,如果看到输出结果,并且没有错误信息,那就说明 Spark 安装成功了!🎉

七、个人小贴士📝

1、多节点部署:如果是在多台机器上部署 Spark,记得在每台机器上都按照上述步骤操作,并确保网络畅通。

2、版本选择:尽量选择与你的 Hadoop 版本兼容的 Spark 版本,避免不必要的兼容性问题。

3、资源监控:Spark 提供了 Web UI(通常是 http://Master_IP:4040)来监控集群状态和作业进度,别忘了时常看看哦!👀

好啦,以上就是在 CentOS 上安装 Spark 的全过程啦!虽然中间可能会遇到一些小坑,但别担心,多试几次就能搞定。🚀 技术都是练出来的,大胆尝试才是王道!💪

希望这篇文章能帮到你,让你在大数据的道路上越走越远,下次我们再聊更多有趣的技术话题吧!👋