CentOS与Ceph分布式存储:构建高可靠存储架构的实践指南

在数据爆炸式增长的今天,企业对于存储系统的需求已从简单的容量扩展转向高可靠、高性能和易扩展。CentOS作为企业级Linux发行版的代表,与Ceph这一开源分布式存储系统的结合,成为构建现代化存储架构的热门选择,本文将深入探讨CentOS环境下Ceph的部署与优化,帮助用户理解其核心优势及落地方法。

**Ceph的核心价值与适用场景

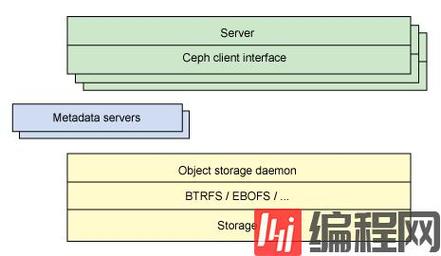

Ceph通过统一的分布式架构,提供对象存储、块存储和文件系统三种接口,能够满足云计算、大数据分析、虚拟化等多样化场景的需求,其核心优势在于:

1、高可靠性:数据通过CRUSH算法自动分散存储于多个节点,避免单点故障;

2、线性扩展:存储容量和性能随节点增加线性提升,适合业务快速增长的环境;

3、自愈能力:节点故障时自动恢复数据副本,保障服务连续性。

对于需要处理海量非结构化数据(如视频、日志)的企业,或基于OpenStack/Kubernetes构建私有云的用户,Ceph是理想的底层存储解决方案。

CentOS部署Ceph的准备工作

在CentOS 7或8上部署Ceph集群,需重点关注以下环节:

1. 硬件规划

节点角色划分:至少包含1个Monitor节点、3个OSD(对象存储守护进程)节点;

存储介质选择:建议使用SSD作为日志盘,HDD作为数据盘,以平衡性能与成本;

网络配置:分离公网(客户端访问)与集群内部通信网络,建议采用10GbE及以上带宽。

2. 系统环境配置

- 禁用SELinux与防火墙(或配置放行规则);

- 配置NTP时间同步,避免节点间时间偏差导致数据不一致;

- 修改内核参数,优化网络性能(如调整net.core.somaxconn)。

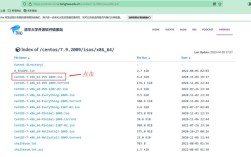

3. 依赖安装

通过YUM添加Ceph官方仓库,安装基础组件:

- sudo yum install -y ceph-deploy ceph-mon ceph-osd

**Ceph集群部署的关键步骤

以部署一个最小化集群(1 Monitor + 3 OSD)为例:

1. 初始化Monitor节点

- ceph-deploy new node1 # 生成初始配置文件

- ceph-deploy mon create-initial

2. 添加OSD存储节点

为每个OSD节点创建数据目录并挂载磁盘:

- ceph-deploy osd create --data /dev/sdb node2

- ceph-deploy osd create --data /dev/sdc node3

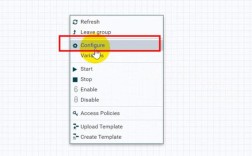

3. 配置CRUSH算法

调整默认存储策略,优化数据分布:

- ceph osd crush tunable optimal # 启用高性能模式

- ceph osd pool set rbd size 3 # 设置数据副本数为3

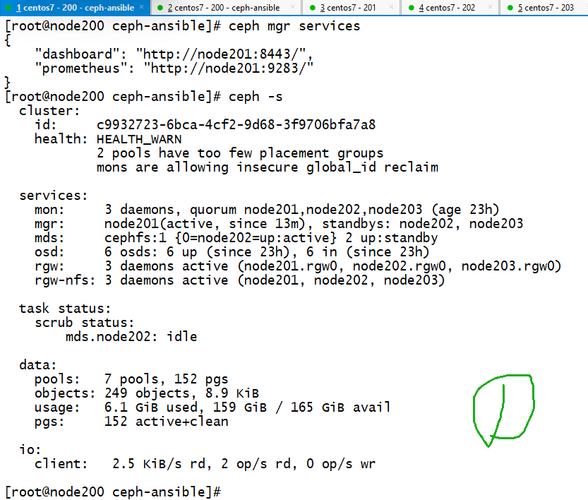

4. 验证集群状态

执行ceph -s查看集群健康状态,需确保所有OSD处于active+clean状态。

**性能调优与运维实践

1. 提升读写性能

缓存分层:将SSD作为缓存层,加速热点数据访问;

PG数量优化:根据集群规模调整Placement Group(PG)数量,避免数据分布不均。

2. 故障排查与恢复

OSD故障处理:通过ceph osd tree定位故障节点,替换磁盘后重新加入集群;

数据平衡:使用ceph osd reweight手动调整数据分布权重。

3. 监控与告警

集成Prometheus+Grafana,实时监控集群IOPS、延迟、存储利用率等指标,设置阈值告警。

Ceph在CentOS环境中的挑战与应对

尽管Ceph功能强大,但在实际部署中仍需注意:

资源消耗:Ceph对CPU和内存需求较高,建议每个OSD节点配置至少16GB内存;

版本兼容性:CentOS 8默认使用Ceph Nautilus版本,需确认与客户端驱动(如RBD)的兼容性;

运维复杂度:建议通过Ansible或Cephadm工具实现自动化运维,降低人工干预成本。

个人观点

CentOS与Ceph的结合,为企业提供了一种高性价比的分布式存储方案,尤其在国产化替代趋势下,其开源特性与社区支持能够有效规避供应商锁定风险,成功落地的关键在于前期的架构设计与持续的运维投入——从硬件选型到参数调优,每一步都需要贴合业务的实际需求,对于技术团队而言,掌握Ceph不仅意味着构建了一套可靠的存储基础设施,更是向云原生架构演进的重要基石。