CUDA编译报错:问题解析与解决方案

在GPU加速计算中,CUDA编译是开发者绕不开的关键步骤,无论是新手还是经验丰富的程序员,都可能遇到nvcc编译器抛出的报错信息,这些错误轻则导致程序无法运行,重则耗费数小时排查,本文将从实际场景出发,梳理常见的CUDA编译报错类型,并提供针对性的解决思路。

一、为什么CUDA编译报错如此棘手?

CUDA编译涉及多层级的技术栈:硬件架构、驱动版本、编译器配置、代码语法等任一环节出问题都可能触发报错。nvcc的报错信息有时较为隐晦,例如"identifier is undefined"可能由头文件缺失、GPU架构不匹配或环境变量错误导致,定位问题需要结合上下文综合分析。

**二、高频报错场景与应对策略

1. 语法错误:看似低级,实则暗藏细节

// 示例:线程索引使用错误

__global__ void kernel(float* data) {

int idx = threadIdx.x + blockIdx.x * blockDim.x;

data[idx] *= 2; // 若idx越界,可能触发运行时错误

}典型报错:

error: calling a __host__ function from a __global__ function is not allowed

原因:在设备函数(__global__或__device__修饰)中调用了仅支持主机(CPU)的函数。

解决方案:

- 检查是否误用C标准库函数(如printf需CUDA 6.0+且需在设备代码中开启支持)。

- 使用CUDA内置函数替代,例如用__powf代替pow。

2. 环境配置问题:隐形的“拦路虎”

案例:编译时出现"CUDA driver version is insufficient for CUDA runtime version"。

排查步骤:

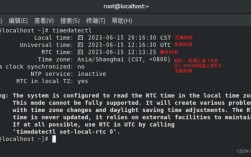

1、运行nvidia-smi查看驱动版本;

2、通过nvcc --version确认CUDA Toolkit版本;

3、比对[NVIDIA官方文档](https://docs.nvidia.com/cuda/cuda-toolkit-release-notes/index.html)的版本兼容性表。

根治方案:

- 升级GPU驱动至CUDA Toolkit要求的最低版本以上;

- 若环境受限无法升级,则降级CUDA Toolkit版本。

3. 硬件兼容性:代码与架构不匹配

典型报错:

ptxas fatal: Value 'sm_35' is not defined for option 'gpu-architecture'

原因:编译时指定的计算能力(如-arch=sm_35)超出当前GPU支持的架构范围。

验证方法:

- 执行deviceQuery示例程序(CUDA Samples内置)获取设备计算能力;

- 查询[NVIDIA GPU产品规格](https://developer.nvidia.com/cuda-gpus)。

编译参数调整:

nvcc -arch=sm_70 -o program program.cu # 根据实际GPU架构修改

4. 资源超限:线程与内存的“天花板”

报错特征:

"too many resources requested for launch"

"CUDA error: out of memory"

调试技巧:

- 使用cudaGetLastError()捕获具体错误代码;

- 通过cudaDeviceProp结构体查询设备的线程块限制、共享内存大小;

- 优化内核设计:减少单个线程块的线程数,或拆分计算任务。

**三、系统化调试方法论

**1. 分阶段验证法

步骤一:剥离复杂逻辑,编写最小测试代码(如仅启动空内核);

步骤二:逐行添加功能,每次编译确认是否触发报错;

步骤三:使用printf或cout在主机代码中打印中间变量。

**2. 工具链辅助

Nsight Systems:分析内核执行时间线,定位资源竞争;

cuda-memcheck:检测内存越界、未初始化访问;

CUDA-GDB:断点调试设备代码。

**四、防患于未然:编码规范建议

1、头文件包含顺序:优先放置CUDA相关头文件(如<cuda_runtime.h>),避免与C++标准库冲突;

2、宏定义隔离:使用#ifdef __CUDACC__区分主机与设备代码;

3、版本控制:在项目文档中明确记录CUDA Toolkit、驱动版本及GPU型号。

观点

CUDA编译报错本质上是开发环境与代码逻辑矛盾的显性表现,与其被动应对错误,不如主动建立“防御性编程”思维:在编写内核前,明确目标硬件规格;在调用API时,严格检查返回状态;在项目初期,固化开发环境版本,这种工程化思维不仅能减少报错频率,更能提升GPU代码的可维护性。